Universeller Detektor erkennt generierte Bilder

9. März 2020Universeller Detektor erkennt generierte Bilder

New York, 9.3.2020

UC Berkeley und Adobe Research haben einen „universellen“ Detektor eingeführt, der reale Bilder von generierten Bildern unterscheiden kann, unabhängig davon, welche Architekturen und / oder Datensätze für das Training verwendet wurden.

Die heutigen AI-gesteuerten Bilderzeugungstechniken, die auf GANs (generativen gegnerischen Netzwerken) und anderen Methoden basieren, können unglaublich realistische Bilder erzeugen, die bekanntermaßen schwer von realen Bildern zu unterscheiden sind. Diese Bilderzeugungstechnologie kann eine ernsthafte Bedrohung für die Gesellschaft darstellen, da gefälschte Bilder die Sichtweise der Menschen auf die Welt beeinflussen und die öffentliche Meinung und sogar Wahlen manipulieren können. In den falschen Händen kann diese Technologie auch als Belästigungsinstrument verwendet werden und die KI-Sicherheits- und Sicherheitssysteme beeinträchtigen.

Das Identifizieren von AI-generierten Bildern ist jedoch technisch anspruchsvoll. Obwohl das Erkennen eines Bildes, das durch eine bestimmte Technik erzeugt wurde, relativ einfach sein kann, mangelt es solchen Ansätzen an Verallgemeinerungsfähigkeit, weil die Bilderzeugungsmethoden mit unterschiedlichen Trainingsdatensätzen, Netzwerkstrukturen, Verlustfunktionen und sogar Bildvorverarbeitungsverfahren sehr unterschiedlich sind . Es bleibt eine Herausforderung für einen Klassifikator, der darauf trainiert ist, einen Ansatz zu erkennen, um bei Bildern, die von anderen Modellen erzeugt werden, effektiv zu sein.

Um dies zu beheben, haben UC Berkeley und Adobe Research einen „universellen“ Detektor eingeführt, der reale Bilder von generierten Bildern unterscheiden kann, unabhängig davon, welche Architekturen und / oder Datensätze für das Training verwendet wurden.

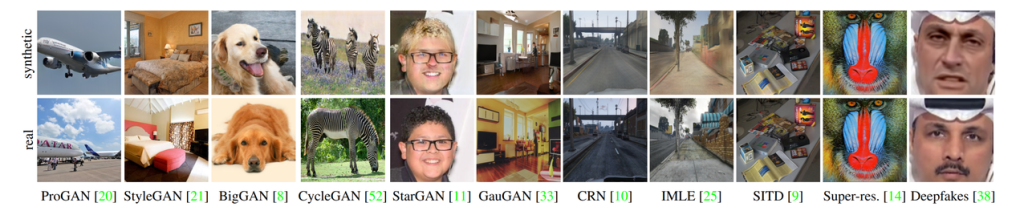

Die Forscher sammelten 11 verschiedene CNN-basierte Bildgeneratormodelle – hauptsächlich GANs -, die bei weitem das häufigste Design für generative CNNs sind. Sie verwendeten zunächst ProGAN, um einen universellen Klassifikator zu trainieren, und testeten ihn gegen die anderen CNN-basierten Bildgeneratoren.

Die Testergebnisse zeigen, dass Forensikmodelle, die auf CNN-generierten Bildern trainiert wurden, eine Verallgemeinerung auf andere zufällige CNN-Modelle aufweisen können. Die Forscher entdeckten auch, dass die Datenerweiterung sowohl für die Generierung als auch für die Vielfalt der Trainingsbilder von entscheidender Bedeutung ist. Am Beispiel von BigGAN – mit Erweiterungen verbessert sich der durchschnittliche Präzisionswert (AP) signifikant von 72,2 auf 88,2. Die Leistung für andere Modelle (CycleGAN, GauGAN) wurde ebenfalls verbessert (84,0 auf 96,8 bzw. 67,0 auf 98,1). Im Allgemeinen hilft das Training mit Augmentation dabei, die Leistung zu steigern.

Die Forscher fanden auch heraus, dass sich AP verbessert, wenn die Anzahl der verwendeten Klassen von 2 auf 16 steigt. Dies gilt jedoch nur bis zu einem gewissen Punkt, da es nur eine minimale Verbesserung gibt, wenn die Anzahl der Klassen von 16 auf 20 erhöht wird.

Das Papier CNN-generierte Bilder sind überraschend leicht zu erkennen: arXiv