Der Energieverbrauch von Rechenzentren steigt exponentiell – und die Folgen?

10. März 2020Der Energieverbrauch von Rechenzentren steigt exponentiell – und die Folgen?

New York, 10.3. 2020

Die Nachfrage nach Rechenzentren ist in den letzten zehn Jahren explodiert, um mit der zunehmenden Nutzung von Anwendungssoftware, sozialen Medien, Videos und mobilen Apps Schritt halten zu können. Welche Folgen hat das? Schließlich fressen diese Computerkathedralen Strom?

Seit 2010 hat sich die Zahl der Rechenzentren mehr als versechsfacht . Eine kürzlich in „ Science“ veröffentlichte Studie kommt zu dem erstaunlichen Schluss, dass sich deren Energieverbrauch aufgrund enormer Verbesserungen der Energieffizienz kaum geändert hat. Dennoch macht der Bericht klar, dass es keine Garantie dafür gebe, dass dieser Trend angesichts datenhungriger neuer Technologien wie künstlicher Intelligenz und 5G fortgesetzt werden kann.

Frühere Analysen haben gezeigt, dass sich der Energieverbrauch im Rechenzentrum in den letzten zehn Jahren mindestens verdoppelt hat. Die neue Studie weist aber darauf hin, das frühere Studien in der Regel Verbesserungen der Energieeffizienz nicht berücksichtigt haben. Das neue Papier wurde von führenden Experten der Northwestern University, des Lawrence Berkeley National Laboratory und des Forschungsunternehmens Koomey Analytics verfasst.

Im Jahr 2010 verbrauchten Rechenzentren auf der ganzen Welt rund 194 Terawattstunden Energie oder 1 Prozent des weltweiten Stromverbrauchs, heißt es in der Studie. Bis 2018 hat sich die Rechenkapazität von Rechenzentren versechsfacht, der Internetverkehr verzehnfacht und die Speicherkapazität um den Faktor 25. Die Studie ergab , dass der Energieverbrauch von Rechenzentren in dieser Zeit nur um 6 Prozent auf 205 tWh gestiegen ist .

Der Unterschied ist das Ergebnis von Verbesserungen der Energieeffizienz seit 2010. Der typische Computerserver verbraucht ungefähr ein Viertel der Energie und ungefähr ein Neuntel der Energie, um ein Terabyte Daten zu speichern. Die Virtualisierungssoftware, mit der eine Maschine als mehrere Computer fungieren kann, hat die Effizienz weiter verbessert. Dies gilt auch für den Trend, Server in „Hyperscale“ -Wolken-Computing-Zentren zu konzentrieren. Kühlsysteme sind auch viel schlanker geworden. Einige Technologieunternehmen tauchen Rechenzentren unter Wasser oder bauen sie in der Arktis.

Die Schlussfolgerungen der Studie stießen auf Überraschung und Skepsis. Mike Demler, ein Halbleiteranalyst bei der Linley Group, wünscht sich mehr quantitative Beweise dafür, dass die Hardwareeffizienz die gestiegene Nachfrage überwiegt. Demler vermutet , dass das Bild in China anders sein könnte. „Es gibt keine guten Daten aus China, das wahrscheinlich am schnellsten zum Energieverbrauch von Rechenzentren beiträgt“, behauptet er.

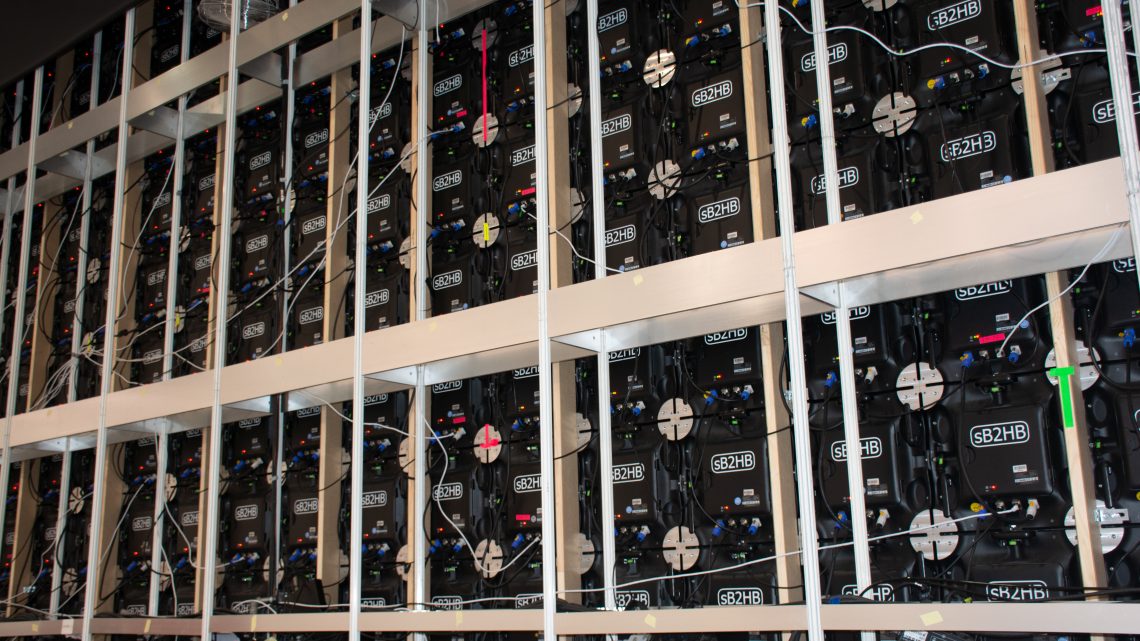

Lotfi Belkhir, ein außerordentlicher Professor an der McMaster University in Kanada, der ein früheres Papier mitverfasst hat, in dem ein etwa zehnfacher Anstieg des Anteils der globalen Treibhausgasemissionen aus Rechenzentren bis 2040 prognostiziert wurde, erwartet keinen linearen Anstieg der Energieeffizienz. Zum einen dränge die Chipindustrie jetzt an die Grenzen des Mooreschen Gesetzes. Zum anderen, so argumentiert er, berücksichtigt das Wissenschaftspapier nicht den Aufstieg von Kryptowährungen und Blockchains, die sehr energieintensiv sind.

Die Autoren des Wissenschaftspapiers selbst sagen, dass ihre Schlussfolgerungen nicht bedeuden würden, dass der Energieverbrauch der Rechenzentrum so bleibe. Die Nachfrage dürfte in den kommenden Jahren durch die Einführung neuer Technologien wie KI sowie autonomer Fahrzeuge deutlich steigen.

KI wird sich wahrscheinlich auf alle Bereiche der Industrie ausbreiten, aber es ist schwierig, die zukünftigen Auswirkungen auf die Energie vorherzusagen. Moderne maschinelle Lernprogramme sind rechenintensiv, aber es gibt Bestrebungen nach effizienteren AI-Chip-Designs und -Algorithmen sowie für die Verwendung effizienterer, spezialisierter Chips, die auf „Edge“ -Geräten wie Smartphones und Sensoren ausgeführt werden. Zudem steht der Einsatz neuer, extrem energiehungriger Technologien wie das Quantencomputing bevor.