Führende Entwickler von KI befürchten, dass sich die Technologie zu schnell entwickelt

10. April 201910.1.2019

In einem kürzlich gegebenen Interview, das auf der Website „FastCompany“ veröffentlicht wurde, antwortete Aleksandra (Saška) Mojsilović, ein IBM Fellow und Mitdirektor von IBM Science for Social Good auf die Frage, wo die KI heute stehe , sie müsse dann zurück denken an jene Zeiten, als die ersten Automobile entwickelt wurden. „Es war der Wilde Westen. Man fuhr links und rechts , es gab keine Stoppschilder oder Sicherheitsgurte.“ Mojsilović wies darauf hin, dass Sicherheitsmaßnahmen für Autos viel später gebaut wurden, nachdem es zu Unfällen gekommen war. Zu diesen Abläufen sehen Mojsilović und ihre Kollegin Francesca Rossi, die globale Leiterin der KI-Ethik von IBM Research, Parallelen in der Welt der künstlichen Intelligenz.

Im Moment scheinen harmlose Anwendungen wie digitale Assistenten, die uns das Wetter ansagen oder eine laufende Lebensmittelliste führen können, oder ein Chatbot, der den Platz eines Kundendienstmitarbeiters einnimmt, zu überwiegen.

Wenn es jedoch darum gehe, die menschliche Entscheidungsfindung zu verbessern, wie z.B. die Einstellung von Kandidaten auf der Grundlage von Verdiensten oder die Ausbildung von Arbeitern, um ethischer zu sein, beginnt alles ein wenig schwammig zu werden. Als Beispiel nennen sie Algorithmen, die bei der Diagnose von Krankheiten oder der Entscheidung, wer einen Kredit erhält, eingesetzt werden. „Es wird für uns sehr unangenehm“, sagt Mojsilović, „wenn die KI anfängt, Entscheidungen zu treffen.“

In einer perfekten Welt müssten wir nicht an die dunkle Seite denken. Maschinen würden schnellere, intelligentere, weniger voreingenommene Entscheidungen treffen als Menschen, alles zum Wohle der Allgemeinheit mit beispielloser Effizienz. Wie die Roboterin Sophia CNBCs Andrew Ross Sorkin sagte: „Du hast zu viel Elon Musk gelesen und zu viele Hollywood-Filme gesehen. Wenn du nett zu mir bist, werde ich nett zu dir sein. Behandle mich wie ein intelligentes Input-Output-System.“

Forscher von Harvard und MIT warnen davor, dass im Falle von Health-Care-Anwendungen die KI dazu verleitet werden kann, eine falsche Diagnose zu stellen, wenn ein Humanarzt oder ein Krankenhaus die Daten zu ihrem eigenen Vorteil geändert hat. Oder die eingehenden Daten könnten fehlerhaft sein.

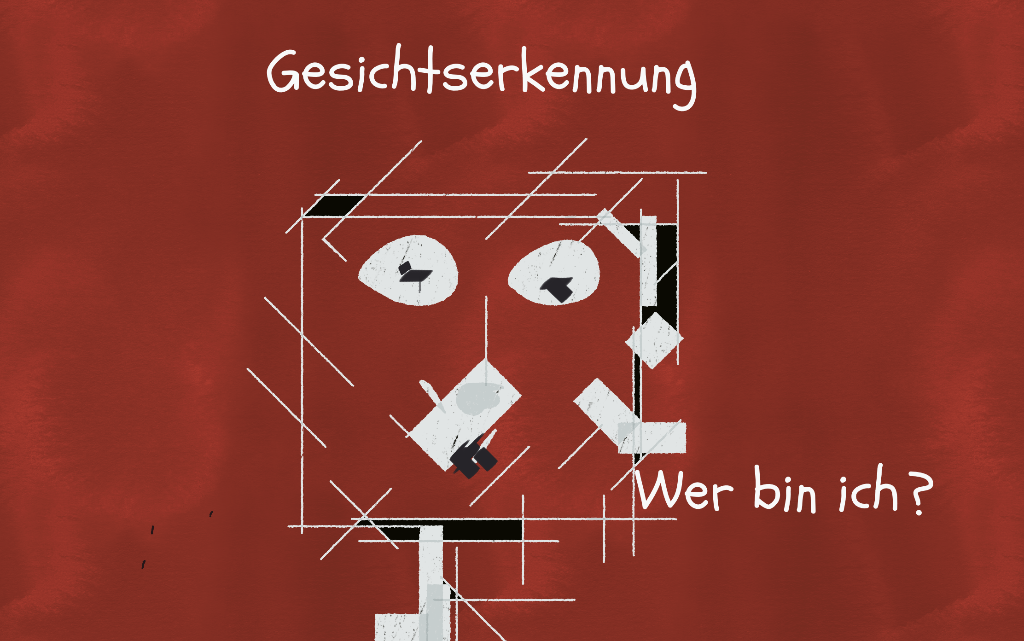

Vor kurzem führte die ACLU einen Test des Gesichtserkennungs-Tools von Amazon durch, und die Software ordnete 28 Personen falsch ein. Darunter war eine unverhältnismäßig große Zahl von farbigen Personen.

Diese Art von Verzerrung ist ein heikles Problem, das Tracey Robinson in Alarmbereitschaft hält, da sie und ihr Team Amelia, die digitale KI-Kollegin von IPsoft, weiter entwickeln.

„Die menschliche Natur macht die vollständige Beseitigung von Verzerrungen unmöglich, weshalb es organisatorisch unerlässlich ist, eine so vielfältige KI-Ausbildungsgruppe wie möglich einzusetzen, sei es kulturell, geographisch, geschlechtsspezifisch, erfahrungsmäßig und fachlich“, sagt Robinson. Wenn ein australisches Unternehmen Amelia einsetzen würde, sagt sie: „Wir würden sicherstellen, dass sie in einer für Australien spezifischen Weise spricht und interagiert, einschließlich der Umgangssprache“.

Robinson glaubt, dass die bedeutendste Entwicklung der KI in den letzten Jahren diese wichtige Anerkennung einer vielfältige Gruppe als integraler Bestandteil der Aufrechterhaltung ethischer Ausbildung war, so dass das Ergebnis ein sehr objektiver digitaler Kollege sein kann.