Neues KI- Modell von GPT-3 kann nun unter anderem auch Mehrdeutigkeit lösen

30. November 2022Neues KI- Modell von GPT-3 kann nun unter anderem auch Mehrdeutigkeit lösen

San Francisco, 30.11.2022

Ein neues KI-Modell der GPT-3-Familie von OpenAI ist in der Lage, längere Inhalte, einschließlich Gedichte und gereimte Lieder, auf einem Niveau zu produzieren, das die Vorgänger nicht erreicht haben.

Das Sprachmodell „text-davinci-003“ erledigt die gleichen Aufgaben, benötigt aber weniger Anweisungen als seine Vorgänger, so OpenAI. Das Modell eignet sich besonders für Aufgaben, die ein tiefes Wissen über ein bestimmtes Thema erfordern, wie etwa kreative Inhalte. Es zeigt eine stark verbesserte Fähigkeit, Lösungen abzuleiten und die Absicht hinter dem Text zu verstehen.

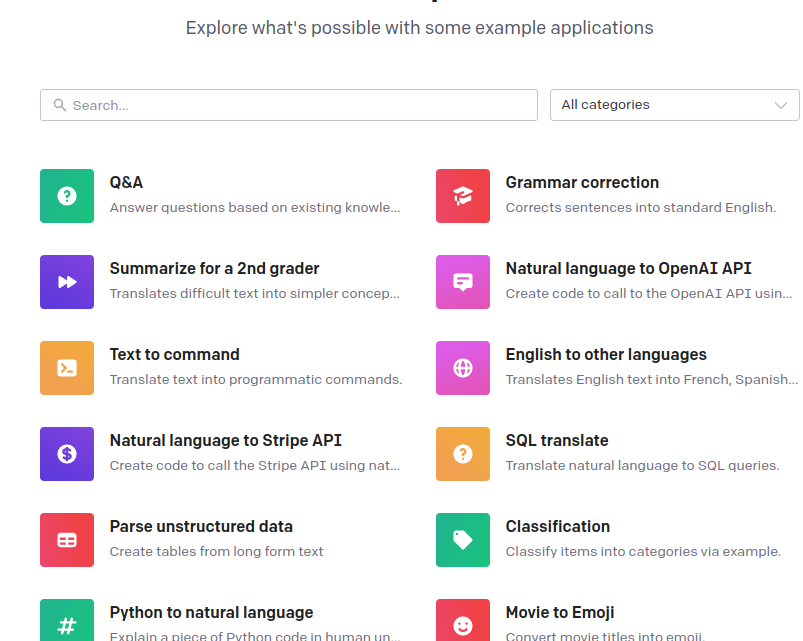

Davinci ist jedoch langsamer und teurer pro API-Aufruf als andere GPT-3-Modelle. Nutzer mit einem OpenAI-Konto können mit den GPT-3-Modellen über die Playground-Webseite des KI-Labors experimentieren, wo sie gegen eine Gebühr Anweisungen zur Generierung von Textergebnissen eingeben können.

Hintergrund:

Die unglaubliche Karriere von BERT

Systeme des maschinellen Lernens haben sich bei den Aufgaben, für die sie trainiert wurden, durch eine Kombination aus großen Datensätzen und leistungsstarken Modellen hervorgetan. Sie sind in der Lage, eine Vielzahl von Funktionen auszuführen, von der Vervollständigung eines Codes bis zur Erstellung von Rezepten. Die vielleicht populärste Aufgabe ist die Generierung von neuen Texten – eine Content-Apokalypse -, die nicht anders als ein Mensch schreibt.

Im Jahr 2018 löste das BERT-Modell (Bidirectional Encoder Representations from Transformers) eine Diskussion darüber aus, wie ML-Modelle lesen und sprechen lernen können. Heute entwickeln sich LLMs oder logisch lernende Maschinen rasant und beherrschen ein breites Spektrum von Anwendungen.

In einer Generation von Text-zu-Allgemeinem mit unglaublichen KI-ML-Modellen ist es wichtig, sich daran zu erinnern, dass die Systeme nicht nur die Sprache verstehen, sondern auch so abgestimmt sind, dass es so aussieht, als würden sie sie verstehen. Apropos Sprache: Die Korrelation zwischen der Anzahl der Parameter und der Ausgereiftheit hat sich bemerkenswert gut gehalten.

Das BERT-Modell

BERT ist ein quelloffener Rahmen für maschinelles Lernen zur Verarbeitung natürlicher Sprache (NLP). BERT wurde entwickelt, um Computern zu helfen, die Bedeutung von mehrdeutiger Sprache in Texten zu verstehen, indem der umgebende Text verwendet wird, um den Kontext herzustellen. Das BERT-Framework wurde mit Text aus Wikipedia trainiert und kann mit Frage- und Antwortdatensätzen feinabgestimmt werden.

BERT steht für Bidirectional Encoder Representations from Transformers und basiert auf Transformers, einem Deep-Learning-Modell, bei dem jedes Ausgangselement mit jedem Eingangselement verbunden ist und die Gewichtung zwischen ihnen dynamisch auf der Grundlage ihrer Verbindung berechnet wird. (Im NLP wird dieser Prozess Aufmerksamkeit genannt.)

In der Vergangenheit konnten Sprachmodelle Texteingaben nur sequentiell lesen – entweder von links nach rechts oder von rechts nach links – aber nicht beides gleichzeitig. BERT ist darauf ausgelegt, in beide Richtungen gleichzeitig zu lesen. Diese Fähigkeit, die durch die Einführung von Transformatoren ermöglicht wurde, wird als Bidirektionalität bezeichnet.

Unter Verwendung dieser bidirektionalen Fähigkeit wurde BERT für zwei verschiedene, aber verwandte NLP-Aufgaben vortrainiert: Maskierte Sprachmodellierung und Vorhersage des nächsten Satzes.

Das Ziel des Masked Language Model (MLM)-Trainings ist es, ein Wort in einem Satz zu verstecken und dann das Programm anhand des Kontexts des versteckten Worts vorhersagen zu lassen, welches Wort versteckt (maskiert) wurde. Das Ziel des Trainings für die Vorhersage des nächsten Satzes ist es, das Programm vorhersagen zu lassen, ob zwei gegebene Sätze eine logische, sequentielle Verbindung haben oder ob ihre Beziehung einfach zufällig ist.

Hintergrund

Transformers wurden erstmals 2017 von Google eingeführt. Zum Zeitpunkt ihrer Einführung verwendeten Sprachmodelle hauptsächlich rekurrente neuronale Netze (RNN) und Faltungsneuronale Netze (CNN), um NLP-Aufgaben zu bewältigen.

Obwohl diese Modelle kompetent sind, wird der Transformer als eine bedeutende Verbesserung angesehen, da er im Gegensatz zu RNNs und CNNs keine Sequenzen von Daten benötigt, die in einer bestimmten Reihenfolge verarbeitet werden müssen. Da Transformers Daten in beliebiger Reihenfolge verarbeiten können, ist es möglich, mit größeren Datenmengen zu trainieren, als dies vor ihrer Existenz möglich war. Dies wiederum erleichterte die Erstellung von vortrainierten Modellen wie BERT, das vor seiner Veröffentlichung mit großen Mengen an Sprachdaten trainiert wurde.

Im Jahr 2018 stellte Google BERT vor und stellte es als Open Source zur Verfügung. In seiner Forschungsphase erzielte das Framework bahnbrechende Ergebnisse bei 11 Aufgaben zum Verständnis natürlicher Sprache, darunter Stimmungsanalyse, semantische Rollenbeschriftung, Satzklassifizierung und Disambiguierung von polysemen Wörtern, also Wörtern mit mehreren Bedeutungen.

Die Bewältigung dieser Aufgaben unterscheidet BERT von früheren Sprachmodellen wie word2vec und GloVe, die bei der Interpretation von Kontext und polysemen Wörtern eingeschränkt sind. BERT geht effektiv auf Mehrdeutigkeit ein, die nach Ansicht von Forschern auf diesem Gebiet die größte Herausforderung beim Verstehen natürlicher Sprache darstellt. Es ist in der Lage, Sprache mit einem relativ menschenähnlichen „gesunden Menschenverstand“ zu parsen.

BERT wurde jedoch nur mit einem unbeschrifteten, reinen Textkorpus trainiert (nämlich der gesamten englischen Wikipedia und dem Brown Corpus). Es lernt weiterhin unüberwacht aus dem unmarkierten Text und verbessert sich selbst dann, wenn es in praktischen Anwendungen eingesetzt wird (z. B. bei der Google-Suche). Sein Vortraining dient als Basisschicht für das „Wissen“, auf dem es aufbauen kann. Von dort aus kann sich BERT an die ständig wachsende Menge an durchsuchbaren Inhalten und Abfragen anpassen und auf die Spezifikationen des Benutzers abgestimmt werden. Dieser Prozess wird als Transfer-Lernen bezeichnet.

Wie bereits erwähnt, wird BERT durch die Forschung von Google zu Transformers ermöglicht. Der Transformator ist der Teil des Modells, der BERT die erhöhte Fähigkeit verleiht, Kontext und Mehrdeutigkeit in der Sprache zu verstehen. Der Transformator tut dies, indem er ein bestimmtes Wort im Zusammenhang mit allen anderen Wörtern in einem Satz verarbeitet, anstatt sie einzeln zu verarbeiten. Durch die Betrachtung aller umgebenden Wörter ermöglicht der Transformer dem BERT-Modell, den gesamten Kontext des Wortes zu verstehen und somit die Absicht des Suchenden besser zu erfassen.

Dies steht im Gegensatz zu der traditionellen Methode der Sprachverarbeitung, der so genannten Worteinbettung, bei der frühere Modelle wie GloVe und word2vec jedes einzelne Wort auf einen Vektor abbilden, der nur eine Dimension, einen Splitter, der Bedeutung dieses Wortes darstellt.

Diese Modelle zur Einbettung von Wörtern erfordern große Datensätze mit markierten Daten. Sie eignen sich zwar für viele allgemeine NLP-Aufgaben, versagen aber bei der kontextlastigen, prädiktiven Beantwortung von Fragen, da alle Wörter in gewisser Weise auf einen Vektor oder eine Bedeutung festgelegt sind. BERT verwendet eine Methode der maskierten Sprachmodellierung, um zu verhindern, dass das Wort im Fokus „sich selbst sieht“, d. h. unabhängig von seinem Kontext eine feste Bedeutung hat. BERT ist dann gezwungen, das maskierte Wort allein anhand des Kontexts zu identifizieren. In BERT werden Wörter durch ihre Umgebung definiert, nicht durch eine vorher festgelegte Identität. In den Worten des englischen Linguisten John Rupert Firth: „Du sollst ein Wort an der Gesellschaft erkennen, die es umgibt.